Am 24. Oktober 2019 hat Google mit der Veröffentlichung des BERT Updates einen gewaltigen Meilenstein in der Weiterentwicklung des Google Algorithmus gesetzt und damit für viel Aufregung in der SEO Szene gesorgt. Laut der offiziellen Mitteilung handelt es sich um das größte Algorithmus Update der letzten fünf Jahre, welches 10% aller Suchanfragen betrifft. Gestern hat Google angekündigt, dass das Update nun weltweit für mehr als 70 Sprachen ausgerollt wird. Aufgrund dieses weitreichenden Einflusses ist es wichtig zu verstehen, wie BERT funktioniert und auf welche Weise das Update die Google Suche beeinflusst. In diesem Beitrag erklären wir Dir deshalb, was BERT für SEO bedeutet und welche weiteren Chancen sich dadurch für Deine Website ergeben.

Table of Contents

Was ist BERT?

BERT ist nicht nur der Name des Google Updates, sondern auch von Googles neuester NLP-Technologie (NLP = Natural Language Processing), die Computern dabei hilft, menschliche Sprache zu verstehen. Das Besondere an dieser Technologie ist, dass bei der Analyse von Sätzen die Begriffe links und rechts eines bestimmten Wortes gleichzeitig verarbeitet werden können. Dieses Prinzip wird als “Bidirektionalität” bezeichnet und ermöglicht eine genauere Interpretation des Kontexts und der Bedeutung des betrachteten Begriffs. Google nutzt diese Technik im Suchalgorithmus, um besser zu verstehen, wonach Nutzer wirklich suchen.

Am Ende dieses Artikels erklären wir die technischen Grundlagen von BERT im Detail, sodass Du die Funktionsweise und den Einfluss auf die Google-Suche noch besser nachvollziehen kannst. Möchtest Du direkt mit dem technischen Teil starten? Dann klicke hier!

Zu Beginn wurde BERT nur für englische Suchanfragen in den USA implementiert, inzwischen ist Google aber dabei, das Update auf mehr als 70 Sprachen weltweit auszuweiten. Bing nutzt BERT laut eigener Aussage übrigens schon seit April und hat die Technologie bereits weltweit im Einsatz.

Wie verbessert BERT die Google Suche?

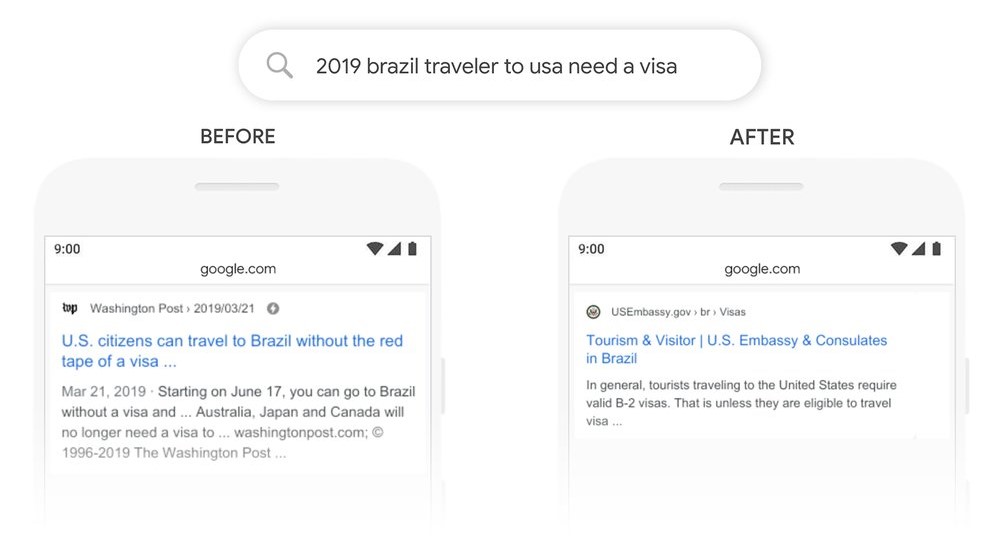

Google erklärt in der offiziellen Mitteilung, dass BERT der Suchmaschine in erster Linie dabei hilft, lange Suchanfragen zu verstehen, die als Frage oder Satz formuliert sind (sog. „conversational“ Anfragen). Als Beispiel nennt Google “2019 brazil traveler to usa need a visa”, was in etwa mit “2019 brasilianischer reisender nach usa brauche visa” übersetzt werden kann. Vor dem BERT-Update wurden für diese Anfrage Suchergebnisse für US Bürger, die nach Brasilien reisen wollen, ausgeliefert. BERT erkennt allerdings, dass “to” in dieser Anfrage ein wichtiges Wort ist und ändert daher die Ergebnisse:

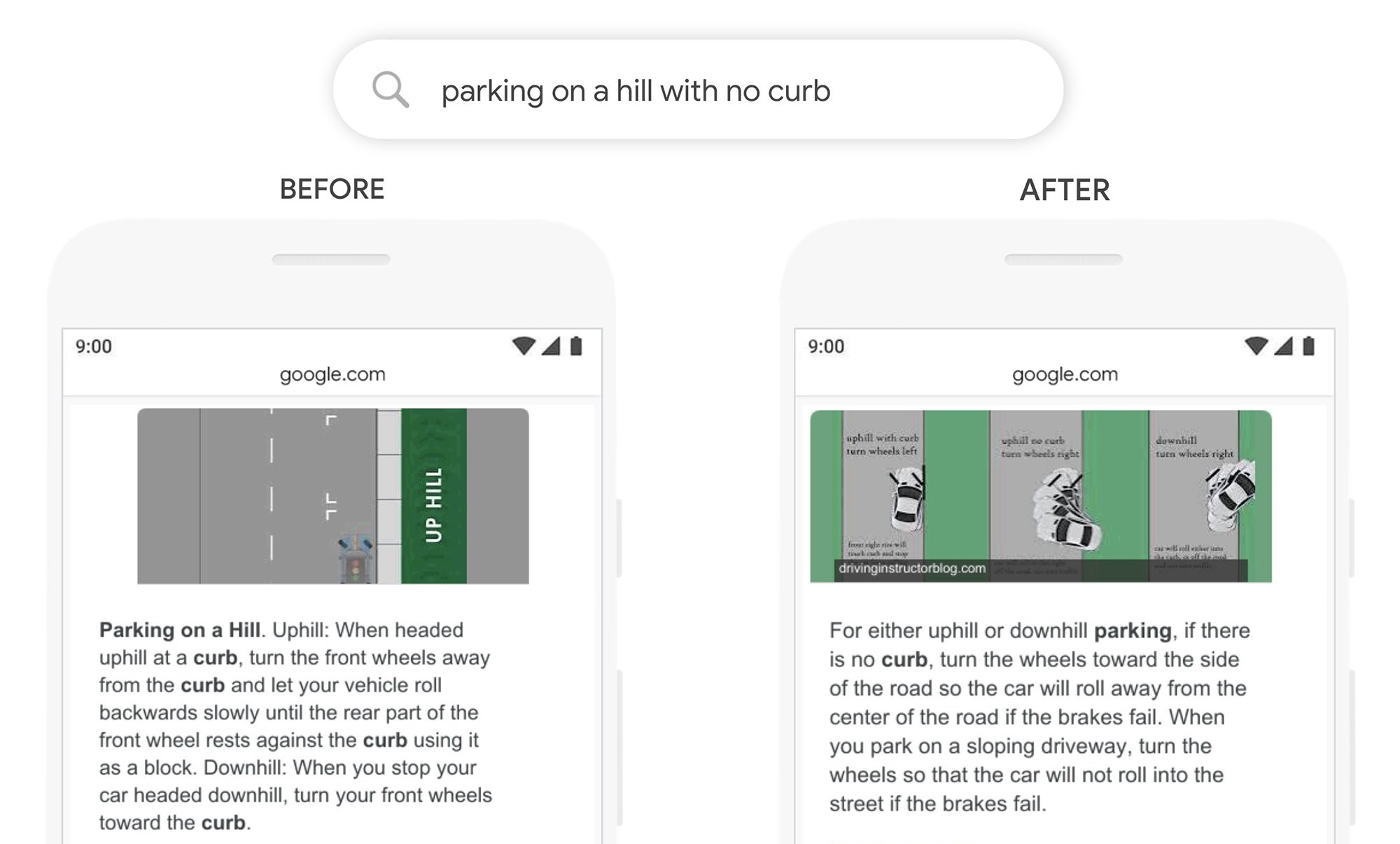

Laut Google hilft BERT außerdem dabei, die Qualität von Featured Snippets zu verbessern. Hier ein Beispiel:

Suchanfragen wie diese (“parking on a hill with no curb” = “parken auf einem hügel ohne bordstein”) waren für Google vor dem Update nur schwer zu verstehen. Damals wurden Suchergebnisse zurückgegeben, die erklärten, wie man auf einem Hügel mit Bordstein parkt.

Wie oben zu sehen ist, ändert sich das durch BERT, da der Algorithmus nun erkennt, wie wichtig das Wort “no” in diesem Satz ist. Das neue Featured Snippet beantwortet die Anfrage des Users somit viel besser.

BERT schaut sich dabei immer nur die Suchanfrage des Users an, d.h. es wird keine neue Bewertung von Webseiten vorgenommen oder den einzelnen Seiten ein Wert zugewiesen. Dies hat Danny Sullivan von Google offiziell auf Twitter bestätigt:

BERT doesn't assign values to pages. It's just a way for us to better understand language.

— Danny Sullivan (@dannysullivan) October 30, 2019

BERT verändert also nicht das Ranking von Websites, sondern ist lediglich dafür da, Googles Verständnis von natürlicher Sprache zu verbessern.

BERT und RankBrain

Google hat RankBrain im Jahr 2015 aus dem selben Grund veröffentlicht wie BERT 2019: um besser zu verstehen, wonach Nutzer wirklich suchen und ihnen die bestmöglichen Suchergebnisse zu liefern. RankBrain analysiert hierfür allerdings nicht nur die Suchanfragen von Usern, sondern auch den Content von Webseiten. Für Google war das damals ein Durchbruch für die semantische Suche, bei der es darum geht, die Suchabsicht eines Nutzers sowie den Kontext seiner Suchanfrage und die Beziehung zwischen den einzelnen Suchbegriffen zu erkennen.

Das BERT-Update macht RankBrain nicht überflüssig, sondern ergänzt es lediglich. Googles Algorithmus entscheidet für jede Suchanfrage, welche der beiden Technologien besser für die Interpretation geeignet ist, und nutzt dann entweder diese oder eine Kombination aus beiden.

BERTs (unbemerkter) Einfluss auf die Google Rankings

Google bezeichnet BERT als riesiges Update, das 10% aller Suchanfragen beeinflusst. Dennoch haben die meisten SEOs seit der Veröffentlichung des Updates keine signifikanten Auswirkungen auf ihre Rankings bemerken können. Du fragst Dich, woran das liegt? Ganz einfach: BERT betrifft hauptsächlich konversationelle Suchanfragen und Long-Tail Keywords, wo Ranking-Veränderungen häufig unbemerkt bleiben.

Was bedeutet BERT für SEO?

Auch wenn es sich bei BERT um ein großes und wichtiges Update handelt, dass die Suchergebnisse für viele User verbessert, wird sich im Bereich SEO nicht viel ändern, wie Danny Sullivan bestätigt:

There's nothing to optimize for with BERT, nor anything for anyone to be rethinking. The fundamentals of us seeking to reward great content remain unchanged.

— Danny Sullivan (@dannysullivan) October 28, 2019

Wie Du siehst, kannst Du Deine Website also nicht wirklich für BERT optimieren. Stattdessen bleibt hochwertiger Content der wichtigste SEO Erfolgsfaktor, auf den Du dich konzentrieren solltest – das ist jetzt sogar noch wichtiger als es vorher schon war. BERT hat nicht das Ziel, Websites zu bestrafen, sondern die Suchintention von Usern zu verstehen und ihnen genau das zu liefern, wonach sie suchen. Konzentriere Dich einfach darauf, Deiner Zielgruppe hochwertigen Content zu liefern, statt “SEO Texte” für Google zu schreiben.

Das bedeutet allerdings nicht, dass BERT für Webseitenbetreiber komplett irrelevant ist. Tatsächlich bringt die neue NLP Technologie sogar einige Chancen mit sich, wie z.B.:

- Trainieren eines eigenen Systems zur Beantwortung von Fragen: Die BERT-Technologie ist Open-Source, d.h. Du kannst sie selbst nutzen, um Dein eigenes System zur Beantwortung von Fragen zu trainieren – z.B. für Chatbots auf Deiner Website oder ähnliche Anwendungen.

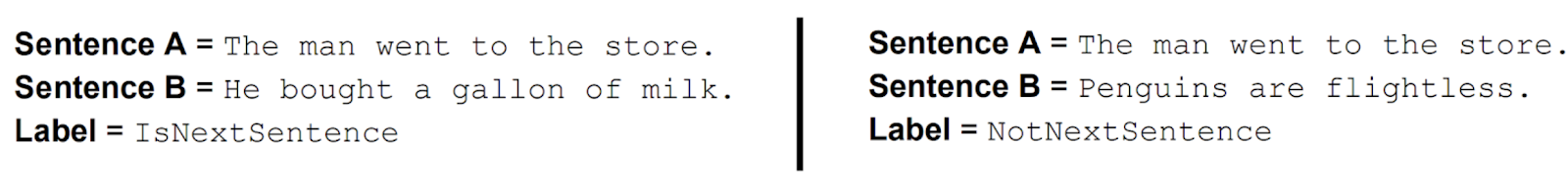

- Verbesserung der Content Qualität: BERT kann bestimmen, ob Satz B in einem Text mit einer hohen Wahrscheinlichkeit auf Satz A folgt (mehr dazu unten). Dies könnte genutzt werden, um zu prüfen, ob die Texte auf einer Website logisch strukturiert sind und einem roten Faden folgen.

- Höhere Qualität des Website-Traffics: Durch BERT kann Google Suchergebnisse bereitstellen, die noch besser zu den Bedürfnissen des Nutzers passen. Dies könnte zur Folge haben, dass der Traffic auf Deiner Website von höherer Qualität ist, da weniger Nutzer mit falschen Erwartungen auf Deine Website kommen.

Die technischen Grundlagen von BERT

Natural Language Processing

BERT ist Googles neueste Technik für Natural Language Processing (NLP). Sie beruht auf neuronalen Netzen und wurde bereits letztes Jahr frei zugänglich gemacht. NLP ist eine Form von künstlicher Intelligenz, die Computern dabei hilft, menschliche Sprache zu verstehen und so Kommunikation zwischen Mensch und Maschine ermöglicht. Anwendungen von NLP sind beispielsweise Übersetzungsdienste wie Google Translate oder Tools wie Grammarly, die Texte auf grammatikalische Fehler überprüfen. Weitere Beispiele sind Sprachassistenten wie Amazons Alexa oder Apples Siri. Diese Systeme nutzen Natural Language Understanding (ein Unterbereich von NLP), um zu verstehen, was User tatsächlich wissen oder tun möchten, wenn sie mit den Assistenten sprechen.

NLP hat bisher eine Vielzahl von unterschiedlichen Modellen zur Verarbeitung von menschlicher Sprache genutzt, wie beispielsweise Klassifizierung oder Sentiment-Analyse. Mit BERT ist jedoch ein Durchbruch für NLP gelungen, da die Technologie die elf wichtigsten NLP Modelle kombiniert. Es ist jetzt also möglich, viele verschiedene NLP Aufgaben mit nur einem Modell zu lösen.

BERT im Detail

BERT steht für “Bidirectional Encoder Representations from Transformers”. Das mag kompliziert klingen, ist aber im Grunde sehr simpel, wenn man sich die einzelnen Begriffe von rechts nach links ansieht:

BERT nutzt Transformer – ein Mechanismus, der den Zusammenhang zwischen Wörtern in einem Text erkennt. Dieses Mechanismus besteht aus einem Encoder, der mit Texteingaben gespeist wird, und einem Decoder, der die Lösung für eine bestimmte Aufgabe ausgibt. BERT nutzt allerdings nur den Encoder des Transformers, da BERTs Aufgabe lediglich darin besteht, ein Sprachmodell zu trainieren. Daher kommt auch der Teil “Encoder Representations” im Namen des Updates.

Bidirectional bedeutet ganz einfach, dass Texteingaben nicht nur von links nach rechts oder von rechts nach links (unidirektional) gelesen werden können, sondern dass die gesamte Wortfolge auf einmal verarbeitet wird. So können die Begriffe links und rechts eines bestimmten Wortes gleichzeitig betrachtet werden, um den Kontext dieses Wortes zu verstehen.

Google erklärt das Konzept der Bidirektionalität am Beispielsatz “I accessed the bank account” (auf Deutsch: “Ich griff auf das Bankkonto zu”). Bei einem unidirektionalen Modell würde die Bedeutung des Wortes “bank” lediglich auf Basis der Worte “I accessed the” bestimmt werden. BERT nutzt jedoch sowohl den Teil vor als auch nach dem Wort “bank” – also “I accessed the …. account”.

Dieser bidirektionale Ansatz ist das, was BERT zu einer bahnbrechenden Innovation für Natural Language Processing macht. Durch die gleichzeitige Betrachtung von dem, was vor und nach einem Wort kommt, kann die exakte Bedeutung dieses Wortes noch besser bestimmt werden. Das klingt für uns Menschen zwar sehr simpel, allerdings hat diese Aufgabe Maschinen, die nicht die Fähigkeit zu logischem Denken besitzen, schon immer vor große Schwierigkeiten gestellt.

Wie wird BERT trainiert?

BERTs bidirektionaler Ansatz stellt eine gewisse Herausforderung beim Trainieren des Sprachmodells dar. Klassische unidirektionale Ansätze bestimmen das nächste Wort in einem Satz, indem sie sich die Textsequenz vor dem jeweiligen Wort anschauen, z.B. “Das Kind kam nach _____”. Da BERT den gesamten Kontext berücksichtigen möchte, wird stattdessen eine Trainingsstrategie namens Masking genutzt.

Hierbei erhält BERT im ersten Trainingsschritt vollständige Texte, die alle relevanten Informationen beinhalten. Im nächsten Schritt werden einzelne Wörter in einem Satz durch eine [Maske] ersetzt. BERT betrachtet die Wörter links und rechts dieser Maske und versucht darauf basierend, das fehlende Wort zu bestimmen. Das wird dann mehrmals wiederholt, bis das Ergebnis korrekt ist.

Eine weitere wichtige Trainingsstrategie ist Next Sentence Prediction (NSP). Hier arbeitet BERT mit Satzpaaren, um zu lernen, ob ein Satz im Originaldokument auf einen anderen Satz folgt. Dies ist eine wichtige Technik, um nicht nur die Bedeutung einzelner Wörter und Sätze, sondern auch die Beziehung zwischen Sätzen besser zu verstehen. Hier ein Beispiel:

BERTs Schwachstellen

Auch wenn BERT eine sehr fortschrittliche Technologie liefert, hat das Modell noch seine Schwachstellen. Allyson Ettinger von der University of Chicago hat eine Forschungsarbeit hierzu veröffentlicht, in der sie einige Probleme erklärt, die bei BERT noch auftreten. So hat BERT etwa immer noch Schwierigkeiten dabei, Verneinungen zu erkennen. Das veranschaulichte sie am Satz “a Robin is a ___” (“ein Rotkehlchen ist ein ___”). In diesem Fall hat BERT es geschafft, das Wort “bird” (Vogel) vorherzusagen. Wenn jedoch der Input “a Robin is not a ___” (ein Rotkehlchen ist kein ___) lautete, hat BERT immer noch “bird” vorhergesagt.

(Wenn Du diesen Artikel mit den technischen Grundlagen begonnen hast, kannst Du hier zum Abschnitt „Wie verbessert BERT die Google Suche?“ zurückspringen).

Fazit

BERT ist eine bahnbrechende Technologie, nicht nur für NLP im Allgemeinen, sondern auch für die Google-Suche. Es ist jedoch wichtig zu verstehen, dass BERT nicht die Art und Weise ändert, wie Webseiten gerankt werden, sondern lediglich Googles Verständnis von natürlicher Sprache verbessert. Für Google ist das ein wichtiger Schritt auf dem Weg zum ultimativen Ziel: immer und überall zu verstehen, was User gerade wollen.

Wenn Du noch tiefer in das Thema eintauchen möchtest, solltest Du Dir die weiterführenden Artikel am Ende dieses Beitrags ansehen.

Und für mehr Informationen darüber, wie Du Deine Website für die Google Suche optimierst, können wir Dir die anderen Artikel in diesem Blog sowie unser SEO Wiki ans Herz legen.

Update (Dezember 2019):

Passend zu dem Ansatz, die exakte Suchabsicht von Nutzern zu verstehen, hat Google kurz nach der Implementierung von BERT das November 2019 Local Search Update veröffentlicht. Mit diesem Update hat Google damit begonnen, Neural Matching für die Bestimmung von lokalen Suchergebnissen zu verwenden. Dies ermöglicht es Google zu erkennen, dass ein User nach lokalen Suchergebnissen sucht, auch wenn er nicht den genauen Wortlaut von Unternehmensnamen oder -beschreibungen verwendet.

The use of neural matching means that Google can do a better job going beyond the exact words in business name or description to understand conceptually how it might be related to the words searchers use and their intents…

— Google SearchLiaison (@searchliaison) December 2, 2019

In Anbetracht der rasanten Geschwindigkeit, mit der Google seinen Algorithmus weiterentwickelt, können wir also sehr gespannt darauf sein, was die Zukunft der Google Suche bringt!

Weiterführende Artikel

https://towardsdatascience.com/bert-explained-state-of-the-art-language-model-for-nlp-f8b21a9b6270

https://www.blog.google/products/search/search-language-understanding-bert/

https://ai.googleblog.com/2018/11/open-sourcing-bert-state-of-art-pre.html

https://www.stateofdigital.com/how-bert-can-improve-the-quality-of-your-traffic/

PS: Erhalte neue Blog Artikel direkt in Dein Postfach!

7 Gedanken zu „Google Update: BERT – Das größte Algorithmus Update seit RankBrain“

Sehr gelungener Blog mit vielen Interessenten Themen.

Ich finde die Beiträge von euch Extraklasse. Ausführlich und Kompetent wird alles aufgeklärt.

Die Demoversion von seobility gefällt mir sehr, man hat richtig Spaß dabei. Ich kann es nur weiterempfehlen.

Grüße Alexander

Hallo Alexander,

vielen Dank für das Lob und weiterhin viel Spaß mit unserem Tool! ?

Kann mich meinem Vorredner nur anschließen. In beiden Punkten:

Ich habe auch keine großen Serpschwankungen beobachtet. Und auch dieser Beitrag ist sehr fundiert, übersichtlich und verständlich. Gute Sache!

LG Mario

Vielen Dank, Mario!

Ich bin immer echt begeistert von Euren ausführlichen Artikeln.

Auch dieser ist wieder mehr als gelungen. Sehr informativ und gut strukturiert.

Wir könnten auch keine Veränderung nach dem Update feststellen.

Danke und weiter so ?

Karsten

Vielen lieben Dank, Karsten!